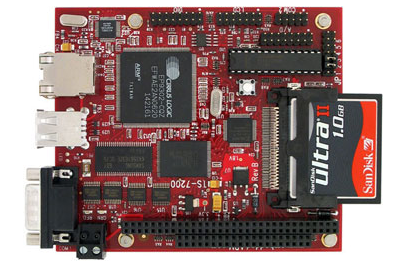

最先端のディスプレイ、ARMボード/コントローラ、メモリ/ストレージの輸入販売

ソリューション提案、企画開発、出荷検査100%、組み立て、技術解析

株式会社エヌ・エム・アールは最先端のディスプレイ(LCD)、ARM系コントローラ、データ収集システム、メモリ/ストレージを輸入して、お客様がすぐご使用できるように技術提案(ソリューション)、システム組み立て、技術解析、不良品の処理等を行い、お客様が安心してご使用できるようなサポートを行っています。

NMR 取扱い製品紹介

株式会社エヌ・エム・アールは、海外の優れた技術、最先端の技術、コストパーフォーマンスの良い製品を輸入し、技術サポートを付けて日本のお客様、あるいは海外のお客様に紹介販売しています。

異文化のもとに開発製造された製品は、とても良い半面、日本人には使いにくい面があります。また、日本での特有の規制があり、その枠に入れないと販売できません。その狭間のコミュニケーション、技術を仲介し、海外の商品でも国内の製品と同じ感覚でご使用いただけるように、十分なサポートを致しています。技術的なサポートはもちろん、書類上のサポート、支払い的なサポート、仕様書などお客様の必要なサポートを実施しています。

異文化のもとに開発製造された製品は、とても良い半面、日本人には使いにくい面があります。また、日本での特有の規制があり、その枠に入れないと販売できません。その狭間のコミュニケーション、技術を仲介し、海外の商品でも国内の製品と同じ感覚でご使用いただけるように、十分なサポートを致しています。技術的なサポートはもちろん、書類上のサポート、支払い的なサポート、仕様書などお客様の必要なサポートを実施しています。

- 国内品以上のサポート

- 新製品、最先端製品

- 最後までやるサポート

NEWS

- その他2025.04.212025年4月 休業日のお知らせ

- その他2025.03.172025年3月 休業日のお知らせ

- その他2025.02.072025年2月 休業日のお知らせ

- その他2024.11.28年末年始 休業期間のお知らせ

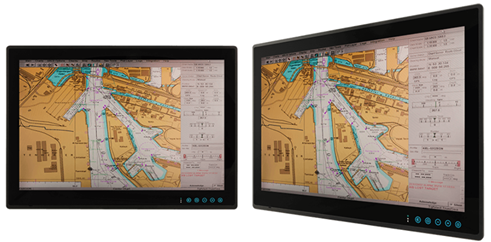

- 製品情報2024.06.24医用モニター「CH-L215-1HDVSD-MD」の情報を公開しました